Cela pourrait être intéressant, en particulier dans le contexte du développement continu de Facebook pour les wearables AR.

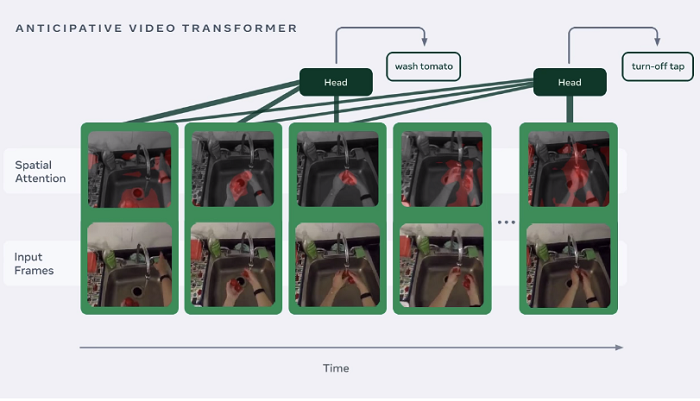

Le réseau social a aujourd’hui a décrit un nouveau processus d’apprentissage automatique appelé ‘Anticipative Video Transformer (AVT)’, capable de prédire les actions futures dans un processus basé sur une interprétation visuelle.

Comme vous pouvez le voir dans cet exemple, le nouveau processus est capable d’analyser une activité, puis d’anticiper quelle action est susceptible d’en résulter.

Ce qui pourrait avoir une gamme d’applications – comme expliqué par Facebook:

« AVT pourrait être particulièrement utile pour des applications telles qu’un « coach d’action » en RA ou un assistant d’IA, en informant quelqu’un qu’il est peut-être sur le point de faire une erreur en accomplissant une tâche ou en réagissant à l’avance avec une invite utile pour la prochaine étape dans une tâche. Par exemple, AVT pourrait avertir quelqu’un que la casserole qu’il est sur le point de prendre est chaude, en fonction des interactions précédentes de la personne avec la casserole.“

Cela ressemble à quelque chose tout droit sorti d’un film de science-fiction, facilitant toutes les nouvelles applications de maison intelligente. Et encore une fois, dans le contexte des lunettes AR, cela pourrait fournir une gamme d’indicateurs utiles pour aider à guider les gens, à la maison ou au travail, dans la réalisation d’une grande variété de tâches.

« Nous entraînons le modèle pour prédire les actions et les fonctionnalités futures en utilisant trois pertes. Premièrement, nous classons les caractéristiques dans la dernière image d’un clip vidéo afin de prédire l’action future étiquetée ; deuxièmement, nous régressons la caractéristique de trame intermédiaire vers les caractéristiques des trames suivantes, ce qui entraîne le modèle à prédire ce qui vient ensuite ; troisièmement, nous entraînons le modèle pour classer les actions intermédiaires. Nous avons montré qu’en optimisant conjointement les trois pertes, notre modèle prédit les actions futures de 10 à 30 % mieux que les modèles entraînés uniquement avec une attention bidirectionnelle.

Ce n’est pas quelque chose que Facebook cherche à déployer tout de suite, mais le potentiel ici est important, et cela pourrait éventuellement faciliter toutes les nouvelles façons de guider les actions des utilisateurs et de minimiser les erreurs en anticipant les étapes futures.

Facebook utilise l’exemple du changement de pneu de voiture, avec des lunettes AR qui vous aident à vous orienter dans la bonne direction, tout en pouvant également servir de rappel pour vos routines matinales, en évaluant visuellement où vous êtes et ce que vous faites.

Vraiment, les applications potentielles ici sont infinies, et lorsque vous considérez également comment Google Glass a évolué pour devenir un outil clé dans les lieux de travail industriels, en fournissant des pointeurs et des instructions pour les applications techniques, le potentiel supplémentaire des appareils AR portables de Facebook est important.

C’est loin d’être un produit destiné aux consommateurs, sous quelque forme que ce soit, mais le projet souligne le développement continu de l’IA de Facebook et souligne l’évolution des fonctionnalités qui sera probablement intégrée à une étape à venir de ses projets de lunettes AR.

Vous pouvez en savoir plus sur le processus Anticipative Video Transformer (AVT) de Facebook ici.