En dépit diverses études, et contre-études, largement financés par les réseaux eux-mêmes, les médias sociaux restent un véhicule extrêmement problématique pour les messages de division et les mouvements nuisibles.

Mais son influence est souvent mal comprise, ou des éléments sont amalgamés pour obscurcir les faits, pour diverses raisons. La véritable influence du social n’est pas nécessairement due aux algorithmes ni à l’amplification en tant qu’éléments de concentration. Le mal le plus important vient de la connexion elle-même et de la capacité de se brancher sur les pensées des personnes que vous connaissez, ce qui n’était pas possible dans le passé.

Voici un exemple – disons que vous êtes entièrement vacciné contre COVID, que vous faites entièrement confiance à la science et que vous faites ce que les responsables de la santé ont conseillé, aucun problème, aucune inquiétude concernant le processus. Mais ensuite, vous voyez un message de votre vieil ami – appelons-le “Dave” – dans lequel Dave exprime ses inquiétudes au sujet du vaccin et pourquoi il hésite à l’obtenir.

Vous n’avez peut-être pas parlé à Dave depuis des années, mais vous l’aimez bien, vous respectez son opinion. Soudainement, ce n’est pas un activiste sans visage et sans nom que vous pouvez facilement rejeter, c’est quelqu’un que vous connaissez, et cela vous fait vous demander s’il y a plus à la poussée anti-vax que vous ne le pensiez. Dave n’a jamais semblé stupide, ni crédule, peut-être que vous devriez y réfléchir un peu plus.

Alors vous le faites – vous lisez les liens publiés par Dave, vous consultez des messages et des articles, peut-être même parcourez-vous quelques groupes pour essayer de mieux comprendre. Peut-être que vous commencez aussi à publier des commentaires sur des articles anti-vax, et tout cela indique aux algorithmes de Facebook que vous êtes intéressé par ce sujet et que vous êtes de plus en plus susceptible de vous engager dans des publications similaires. Les recommandations commencent à changer dans votre flux, vous vous impliquez davantage dans le sujet, et tout cela vous pousse d’un côté ou de l’autre de l’argument, alimentant la division.

Mais cela n’a pas commencé avec l’algorithme, qui est une réfutation fondamentale dans Les contre-arguments de Meta. Cela a commencé avec Dave, quelqu’un que vous connaissez, qui a publié une opinion qui a suscité votre intérêt.

C’est pourquoi des campagnes plus larges visant à manipuler l’opinion publique sont si préoccupantes. le campagnes de perturbation orchestrées par l’Agence russe de recherche Internet à l’approche des élections américaines de 2016 sont l’exemple le plus public, mais des poussées similaires se produisent tout le temps. La semaine dernière, des rapports ont fait surface selon lesquels le gouvernement indien utilisait campagnes de force brute alimentées par des robots sur le social pour « inonder la zone » et déplacer le débat public sur certains sujets en faisant en sorte que des sujets alternatifs soient à la mode sur Facebook et Twitter. De nombreux projets NFT et crypto cherchent maintenant à tirer profit du battage médiatique plus large en utilisant des robots Twitter pour rendre leurs offres plus populaires et plus réputées qu’elles ne le sont.

La plupart des gens, bien sûr, se méfient de plus en plus de telles pressions et remettront plus facilement en question ce qu’ils voient en ligne. Mais tout comme l’escroquerie nigériane classique par e-mail, il ne faut qu’un très petit nombre de personnes pour s’accrocher, et tous ces efforts en valent la peine. Les coûts de main-d’œuvre sont faibles et le processus peut être largement automatisé. Et quelques Daves peuvent finir par avoir un grand impact sur le discours public.

Les motivations de ces campagnes sont complexes. Dans le cas du gouvernement indien, il s’agit de contrôler le discours public et de réprimer d’éventuelles dissidences, tandis que pour les escrocs, il s’agit d’argent. Il existe de nombreuses raisons pour lesquelles de telles poussées sont mises en œuvre, mais il ne fait aucun doute que les médias sociaux ont fourni un connecteur précieux et viable pour ces efforts.

Mais les contre-arguments sont sélectifs. Meta dit que le contenu politique est seulement une petite partie du matériel global partagé sur Facebook. Ce qui est peut-être vrai, mais cela ne compte que les articles partagés, pas les publications personnelles et les discussions de groupe. Meta dit aussi que le contenu qui divise est en fait mauvais pour les affaires parce que Le PDG Mark Zuckerberg explique:

“Nous gagnons de l’argent grâce aux publicités, et les annonceurs nous disent constamment qu’ils ne veulent pas que leurs publicités soient à côté de contenu nuisible ou colérique. Et je ne connais aucune entreprise de technologie qui se propose de créer des produits qui rendent les gens en colère ou déprimés. Les incitations morales, commerciales et de produit vont toutes dans la direction opposée.“

Pourtant, en même temps, Meta propres recherches a également montré le pouvoir de Facebook pour influencer l’opinion publique, en particulier dans un contexte politique.

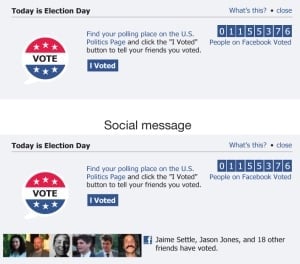

En 2010, environ 340 000 électeurs supplémentaires ont participé aux élections du Congrès américain en raison d’un message Facebook le jour de l’élection boosté par Facebook.

Selon le étudier:

“Environ 611 000 utilisateurs (1%) ont reçu un “message d’information” en haut de leur fil d’actualités, qui les encourageait à voter, fournissait un lien vers des informations sur les bureaux de vote locaux et incluait un bouton cliquable “J’ai voté” et un compteur de Utilisateurs de Facebook qui ont cliqué dessus. Environ 60 millions d’utilisateurs (98 %) ont reçu un « message social », qui comprenait les mêmes éléments mais montrait également les photos de profil de jusqu’à six amis Facebook sélectionnés au hasard qui avaient cliqué sur le bouton « J’ai voté » . Les 1 % d’utilisateurs restants ont été affectés à un groupe de contrôle qui n’a reçu aucun message.”

Les résultats ont montré que ceux qui ont vu le deuxième message, avec des images de leurs relations incluses, étaient de plus en plus susceptibles de voter, ce qui a finalement conduit 340 000 personnes de plus à se rendre aux urnes à la suite du coup de pouce des pairs. Et ce n’est qu’à petite échelle en termes de Facebook, parmi 60 millions d’utilisateurs, la plate-forme se rapprochant désormais de 3 milliards d’actifs mensuels dans le monde.

Il est clair, sur la base des propres preuves de Facebook, que la plate-forme détient en effet un pouvoir d’influence important grâce aux connaissances des pairs et au partage personnel.

Ce n’est donc pas spécifiquement Facebook, ni le tristement célèbre algorithme du fil d’actualités qui sont les principaux coupables de ce processus. Ce sont les gens et ce que les gens choisissent de partager. C’est ce que le PDG de Meta Mark Zuckerberg a a souligné à plusieurs reprises:

“Oui, nous avons de gros désaccords, peut-être plus maintenant qu’à aucun autre moment de l’histoire récente. Mais cela s’explique en partie par le fait que nous mettons nos problèmes sur la table – des problèmes dont on n’a pas parlé pendant longtemps. Plus de personnes provenant de plus de parties de notre société ont une voix que jamais auparavant, et il faudra du temps pour entendre ces voix et les rassembler dans un récit cohérent.“

Contrairement à la suggestion selon laquelle cela cause plus de problèmes, Meta voit Facebook comme un véhicule pour un véritable changement social, que grâce à la liberté d’expression, nous pouvons atteindre un point de meilleure compréhension, et que fournir une plate-forme pour tous devrait, théoriquement, assurer une meilleure représentation et connexion.

Ce qui est vrai d’un point de vue optimiste, mais tout de même, la capacité des mauvais acteurs à influencer également ces opinions partagées est tout aussi importante, et ce sont tout aussi souvent les pensées qui sont amplifiées parmi vos connexions de réseaux.

Alors que faire, au-delà de ce sur quoi les équipes d’application et de modération de Meta travaillent déjà ?

Eh bien, probablement pas grand-chose. À certains égards, la détection de texte répété dans les publications fonctionnerait apparemment, ce que les plates-formes font déjà de différentes manières. Limiter le partage autour de certains sujets peut également avoir un certain impact, mais en réalité, la meilleure voie à suivre est ce que fait Meta, en travaillant à détecter les auteurs de tels, et en supprimant les réseaux amplifiant les contenus douteux.

La suppression de l’algorithme fonctionnerait-elle ?

Peut-être. La dénonciatrice Frances Haugen a souligné l’algorithme du fil d’actualité, et son accent sur l’engagement avant tout, comme un problème clé, car le système est effectivement conçu pour amplifier le contenu qui incite à la dispute.

C’est certainement problématique dans certaines applications, mais cela empêcherait-il Dave de partager ses réflexions sur un problème ? Non, ce ne serait pas le cas, et en même temps, rien n’indique que les Dave du monde obtiennent leurs informations via des sources douteuses, comme celles soulignées ici. Mais les plateformes de médias sociaux et leurs algorithmes facilitent les deux, ils améliorent ce processus et offrent de toutes nouvelles voies de division.

Différentes mesures pourraient être adoptées, mais l’efficacité de chacune est très discutable. Parce qu’une grande partie de cela n’est pas un problème de médias sociaux, c’est un problème de personnes, comme le dit Meta. Le problème est que nous avons maintenant accès aux pensées de tout le monde, et certaines d’entre elles avec lesquelles nous ne serons pas d’accord.

Dans le passé, nous pouvions continuer, parfaitement inconscients de nos différences. Mais à l’ère des médias sociaux, ce n’est plus une option.

Cela, à terme, comme le dit Zuckerberg, nous conduira-t-il à une société plus compréhensive, intégrée et civile ? Les résultats jusqu’à présent suggèrent que nous avons un moyen d’aller de l’avant.