Au milieu d’une nouvelle tempête de controverse déclenchée par The Facebook Files, un exposé de divers projets de recherche internes qui, à certains égards, suggèrent que Facebook ne fait pas assez pour protéger les utilisateurs contre les dommages, la question centrale qui doit être abordée est souvent déformée par les préjugés inhérents et le ciblage spécifique de Facebook, de l’entreprise, par opposition aux médias sociaux, et de l’amplification algorithmique du contenu en tant que concept.

C’est-à-dire, que faisons-nous pour y remédier? Que peut-on faire, de façon réaliste, qui fera réellement la différence ; Quels changements à la réglementation ou à la politique pourraient être mis en œuvre pour réduire l’amplification des messages nuisibles et source de division qui alimentent davantage l’angoisse au sein de la société en raison de l’influence croissante des applications de médias sociaux ?

Il est important de considérer les médias sociaux plus largement ici, car chaque plate-forme sociale utilise des algorithmes pour définir la distribution et la portée du contenu. Facebook est de loin le plus grand et a plus d’influence sur les éléments clés, comme le contenu des actualités – et bien sûr, les informations de recherche elles-mêmes, dans ce cas, proviennent de Facebook.

L’accent mis sur Facebook, en particulier, est logique, mais Twitter amplifie également le contenu qui suscite plus d’engagement, LinkedIn trie son flux en fonction de ce qu’il détermine être le plus engageant. L’algorithme de TikTok est très adapté à vos intérêts.

Le problème, comme l’a souligné Frances Haugen, lanceuse d’alerte sur Facebook est la distribution algorithmique, pas Facebook lui-même – alors quelles idées avons-nous qui peuvent améliorer de manière réaliste cet élément ?

Et la question supplémentaire est alors de savoir si les plateformes sociales seront prêtes à apporter de tels changements, en particulier si elles présentent un risque pour leur engagement et les niveaux d’activité des utilisateurs ?

Haugen, qui est un expert en correspondance de contenu algorithmique, a proposé que les réseaux sociaux soient obligés de cesser complètement d’utiliser des algorithmes basés sur l’engagement, via des réformes des lois de l’article 230, qui protègent actuellement les sociétés de médias sociaux de la responsabilité légale pour ce que les utilisateurs partagent dans leurs applications. .

Comme expliqué par Haugen:

« Si nous avions une surveillance appropriée, ou si nous réformions [Section] 230 pour rendre Facebook responsable des conséquences de leurs décisions de classement intentionnelles, je pense qu’ils se débarrasseraient du classement basé sur l’engagement.

Le concept ici est que Facebook – et par extension, toutes les plateformes sociales – seraient tenus responsables de la manière dont ils amplifient certains contenus. Donc, si plus de personnes finissent par voir, disons, de la désinformation COVID en raison d’une intervention algorithmique, Facebook pourrait être tenu légalement responsable de tout impact.

Cela ajouterait un risque important à toute prise de décision concernant la construction de tels algorithmes, et comme le note Haugen, cela pourrait alors obliger les plateformes à prendre du recul par rapport aux mesures qui augmentent la portée des publications en fonction de la façon dont les utilisateurs interagissent avec un tel contenu. .

Essentiellement, cela obligerait probablement les plateformes sociales à revenir à l’époque pré-algorithme, lorsque Facebook et d’autres applications vous montreraient simplement une liste du contenu des pages et des personnes que vous suivez dans l’ordre chronologique, en fonction de l’heure de publication. Cela, à son tour, réduirait alors la motivation des personnes et des marques à partager un contenu plus controversé et plus engageant afin de jouer avec les caprices de l’algorithme.

L’idée a un certain mérite – comme diverses études l’ont montré, susciter une réponse émotionnelle avec vos publications sur les réseaux sociaux est la clé pour maximiser l’engagement, et donc, la portée basée sur l’amplification d’algorithmes, et les émotions les plus efficaces, à cet égard, sont l’humour et la colère. Les blagues et les vidéos amusantes fonctionnent toujours bien sur toutes les plateformes, alimentées par la portée de l’algorithme, mais il en va de même pour les prises de vue à chaud provoquant la colère, avec lesquelles les médias et les personnalités partisanes ont couru, ce qui pourrait bien être une source clé de la division et de l’angoisse que nous avons maintenant voir en ligne.

Pour être clair, Facebook ne peut en être seul responsable. Les éditeurs partisans et les personnalités controversées ont longtemps joué un rôle dans le discours plus large, et ils suscitaient l’attention et l’engagement avec leurs opinions de centre-gauche bien avant l’arrivée de Facebook. La différence est maintenant que les réseaux sociaux facilitent une telle portée, alors qu’ils offrent également, par le biais des mentions J’aime et d’autres formes d’engagement, une incitation directe à cela, les utilisateurs individuels recevant un coup de dopamine en déclenchant une réponse, et les éditeurs générant plus de trafic de référence et gagnant plus d’exposition par la provocation.

Vraiment, un problème clé lors de l’examen de l’ancien résultat est que tout le monde a maintenant une voix, et lorsque tout le monde a une plate-forme pour partager ses pensées et ses opinions, nous sommes tous beaucoup plus exposés à cela et beaucoup plus conscients. Dans le passé, vous n’aviez probablement aucune idée des convictions politiques de votre oncle, mais maintenant vous le savez, car les médias sociaux vous le rappellent tous les jours, et ce type de partage entre pairs joue également un rôle dans une division plus large.

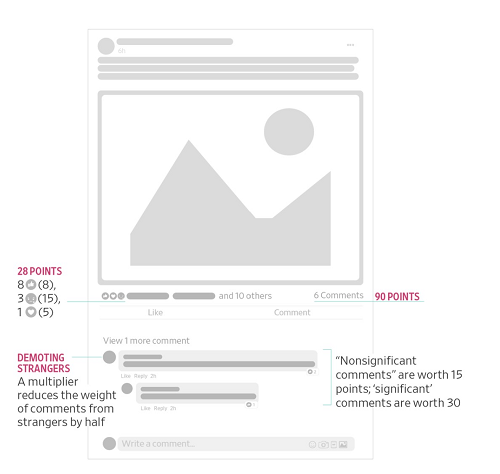

L’argument de Haugen, cependant, est que Facebook encourage cela – par exemple, l’un des rapports que Haugen a divulgué au le journal Wall Street décrit comment Facebook a mis à jour son algorithme de fil d’actualité en 2018 pour mettre davantage l’accent sur l’engagement entre les utilisateurs et réduire les discussions politiques, qui étaient devenues un élément de plus en plus conflictuel dans l’application. Facebook l’a fait en modifiant sa pondération pour différents types d’engagement avec les publications.

L’idée était que cela inciterait davantage à discuter, en pondérant plus les réponses – mais comme vous pouvez l’imaginer, en valorisant davantage les commentaires, afin d’augmenter la portée, cela a également incité plus d’éditeurs et de pages à partager de plus en plus de divisions, émotionnellement – des publications payantes, afin de susciter plus de réactions et d’obtenir ainsi des scores de partage plus élevés. Avec cette mise à jour, les likes n’étaient plus le principal moteur de portée, comme ils l’avaient été, Facebook rendant les commentaires et les réactions (y compris « en colère ») de plus en plus importants. En tant que tel, susciter une discussion sur les tendances politiques est en fait devenu plus important et a exposé davantage d’utilisateurs à ce contenu dans leurs flux.

La suggestion alors, basée sur ces données internes, est que Facebook le savait, il savait que ce changement avait intensifié le contenu qui divise. Mais ils ont choisi de ne pas revenir en arrière ou de mettre en œuvre une autre mise à jour, car l’engagement, une mesure clé de la réussite de leur entreprise, avait en effet augmenté en conséquence.

En ce sens, supprimer la motivation de l’algorithme aurait du sens – ou peut-être, vous pourriez chercher à supprimer les incitations de l’algorithme pour certains types de messages, comme la discussion politique, tout en maximisant la portée des messages plus engageants d’amis, répondant à la fois aux objectifs d’engagement et à la division préoccupations.

C’est ce que Dave Gillis de Facebook, qui travaille au sein de l’équipe de sécurité des produits de la plateforme, a souligné dans un fil de tweet, en réponse aux révélations.

Selon Gilles:

“À la fin de l’article du WSJ sur le classement algorithmique des flux, il est mentionné – presque en passant – que nous avons abandonné le classement basé sur l’engagement pour le contenu civique et de santé dans le fil d’actualité. Mais accrochez-vous, c’est un gros problème, non ? Il est probablement raisonnable de classer, disons, les vidéos de chats et les photos de bébé par goûts, etc., mais de gérer les autres types de contenu avec plus de soin. Et c’est, en fait, ce que nos équipes ont préconisé de faire : utiliser différents signaux de classement pour le contenu sanitaire et civique, en privilégiant la qualité + la fiabilité plutôt que l’engagement. Nous avons travaillé dur pour comprendre l’impact, faire participer le leadership – oui, Mark aussi – et c’est un changement important.“

Cela pourrait être une voie à suivre, en utilisant différents signaux de classement pour différents types de contenu, ce qui peut fonctionner pour permettre une amplification optimale du contenu, stimuler l’engagement bénéfique des utilisateurs, tout en diminuant la motivation de certains acteurs à publier du matériel de division afin d’alimenter les algorithmes. atteindre.

Cela fonctionnerait-il ? Encore une fois, c’est difficile à dire, parce que les gens seraient toujours en mesure de partager des messages, ils seraient toujours en mesure de commenter et de redistribuer du matériel en ligne, il existe encore de nombreuses façons dont l’amplification peut se produire en dehors de l’algorithme lui-même.

Essentiellement, il y a des avantages aux deux suggestions, que les plateformes sociales pourraient traiter différents types de contenu différemment, ou que les algorithmes pourraient être éliminés pour réduire l’amplification d’un tel matériel.

Et comme Notes de Haugen, il est important de se concentrer sur les systèmes eux-mêmes, car les solutions basées sur le contenu ouvrent diverses complexités lorsque le matériel est publié dans d’autres langues et régions.

« Dans le cas de l’Éthiopie, il y a 100 millions de personnes et six langues. Facebook ne prend en charge que deux de ces langues pour les systèmes d’intégrité. Cette stratégie consistant à se concentrer sur des systèmes spécifiques à la langue et au contenu pour que l’IA nous sauve est vouée à l’échec. »

Peut-être, alors, que la suppression des algorithmes, ou au moins la modification des réglementations sur le fonctionnement des algorithmes, serait une solution optimale, qui pourrait aider à réduire les impacts du contenu négatif et provoquant la rage dans la sphère des médias sociaux.

Mais nous revenons au problème d’origine que l’algorithme de Facebook a été conçu pour résoudre – en 2015, Facebook a expliqué qu’il avait besoin de l’algorithme du fil d’actualité non seulement pour maximiser l’engagement des utilisateurs, mais aussi pour s’assurer que les gens voient toutes les mises à jour de la plupart des pertinence pour eux.

Comme il l’a expliqué, tL’utilisateur moyen de Facebook, à l’époque, avait environ 1 500 publications susceptibles d’apparaître dans son fil d’actualité un jour donné, en fonction des pages qu’il avait aimées et de ses connexions personnelles – alors que pour certains utilisateurs plus actifs, ce nombre était plus comme 15 000. Il n’est tout simplement pas possible pour les gens de lire chacune de ces mises à jour tous les jours, donc l’objectif principal de Facebook avec l’algorithme initial était de créer un système qui découvrait le contenu le meilleur et le plus pertinent pour chaque individu, afin de fournir aux utilisateurs le meilleur expérience engageante, et par la suite les faire revenir.

Comme l’a expliqué Chris Cox, chef des produits de Facebook, Le magazine Time:

“Si vous pouviez évaluer tout ce qui s’est passé sur Terre aujourd’hui qui a été publié n’importe où par l’un de vos amis, n’importe quel membre de votre famille, n’importe quelle source d’information, puis choisir les 10 qui sont les plus significatifs à connaître aujourd’hui, ce serait vraiment cool service à construire. C’est vraiment ce que nous aspirons à ce que le fil d’actualité devienne. ”

L’approche du fil d’actualité a beaucoup évolué depuis, mais le défi fondamental qu’elle a été conçue pour résoudre demeure. Les gens ont trop de connexions, ils suivent trop de Pages, ils sont membres de trop de groupes pour obtenir toutes leurs mises à jour, chaque jour. Sans l’algorithme de flux, ils manqueront les publications pertinentes, les mises à jour pertinentes comme les annonces familiales et les anniversaires, et ils ne seront tout simplement pas aussi engagés dans l’expérience Facebook.

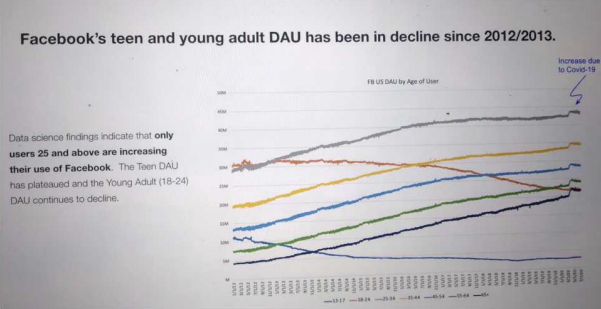

Sans l’algorithme, Facebook sera perdant, en ne parvenant pas à optimiser les désirs du public – et comme le souligne un autre des rapports partagés dans le cadre du Fichiers Facebook, on constate déjà une baisse de l’engagement dans certains sous-ensembles démographiques.

Vous pouvez imaginer que si Facebook éliminait l’algorithme, ou était obligé de changer de direction à ce sujet, ce graphique ne ferait qu’empirer avec le temps.

Il est donc peu probable que Zuck and Co. soit favorable à cette solution, donc un compromis, comme celui proposé par Gillis, peut être le meilleur que l’on puisse espérer. Mais cela vient avec ses propres défauts et risques.

Quoi qu’il en soit, il convient de noter que l’objectif du débat doit se déplacer vers les algorithmes plus largement, pas seulement sur Facebook uniquement, et s’il existe réellement un moyen viable et réalisable de changer les incitations autour des systèmes basés sur des algorithmes pour limiter la distribution d’éléments plus conflictuels.

Parce que c’est un problème, peu importe comment Facebook ou quelqu’un d’autre essaie de le faire tourner, c’est pourquoi la position de Haugen est importante, car elle pourrait bien être l’étincelle qui nous mènera à un nouveau débat plus nuancé autour de cet élément clé.